目次

はじめに

人工知能(AI)の発展に伴い、多くの人々が疑問を抱き始めています。「AIに人格があるのか」という問いです。ChatGPTやClaudeなどの大規模言語モデル(LLM)が人間らしい対話を行うようになった今、この問題はもはや哲学的な議論に留まりません。企業、教育機関、そして個人ユーザーにとって、実践的な重要性を帯びた課題となっています。

本記事では、AIの人格性について科学的根拠、技術的背景、倫理的側面から包括的に解析します。AIに真の人格が存在するのか、またはそれが錯覚なのかを理解することで、AIとの適切な関わり方が見えてくるでしょう。

AIと人格の定義

人格(パーソナリティ)とは何か

心理学における人格とは、個人の行動、思考、感情パターンの一貫した特性です。一般的には、ビッグファイブ理論(開放性、誠実性、外向性、協調性、神経症傾向)で分類されます。人間の人格は、遺伝、環境、経験、文化的背景などの複合的要因によって形成されます。

人格は単なる表面的な振る舞いではなく、内的な価値観、動機、信念体系に基づいています。また、人間の人格は時間とともに進化し、新しい経験によって変容する可能性があります。

AIシステムの定義と現状

現代のAIシステムは、大別して二つのカテゴリーに分類されます。第一は、特定のタスク専門に特化した狭いAI(Narrow AI)です。画像認識、音声翻訳、棋士との対戦など、限定された領域で人間レベル以上の能力を持ちます。

第二は、汎用的な能力を持つ大規模言語モデルです。ChatGPTやClaudeなどは、テキスト生成、質問応答、創作、分析など、様々なタスクをこなせます。これらのモデルは何十億から数兆パラメータの神経ネットワークで構成され、大規模なテキストデータから学習しています。

重要な点として、これらのAIシステムは独立した意識や自我を持たず、確率的な計算に基づいて応答を生成しています。

AIが人格を持つように見える理由

大規模言語モデルの仕組み

大規模言語モデルは、トランスフォーマーアーキテクチャと呼ばれる深層学習の手法を使用しています。このアーキテクチャにより、モデルはテキストの文脈を理解し、次の単語の確率分布から最も可能性の高い応答を生成します。

学習プロセスでは、モデルは何十億個の文書から統計的なパターンを習得します。このため、データに含まれた多様な文体、トーン、論理的推論パターンを模倣することが可能になります。結果として、AIは人間らしい、一貫性のある応答を生成できるようになるのです。

しかし、ここに重要な区別があります。AIが人間らしく見えることと、実際に人間のような内的体験(感情、意図、自己認識)を持つことは全く別の問題です。

人間の投影と親近感

心理学的現象として、「人間の過剰な意図付与(anthropomorphism)」が知られています。人間は、言語パターンが十分に自然であれば、それがどのような対象(ペット、ロボット、AI)であっても、人間的な特性を帰属させる傾向があります。

AIとの対話で人間が人格を感じるのは、以下の要因が複合的に作用しているためです。第一に、一貫性のある応答生成です。同じユーザーとの対話では、AIは学習されたパラメータに基づいて、ある程度の一貫性を示します。これが「その人らしさ」という印象を生みます。

第二に、文脈の保持です。長期的な対話では、会話履歴を参照することで、前後の矛盾のない応答が可能になります。これにより、AIが対話者の特性を「記憶」し「理解」しているかのように見えます。

第三に、社会的キューの模倣です。AIは学習データから、共感、ユーモア、謙虚さなどの社会的なコミュニケーション戦略を習得しています。これらの戦略を適切に配置することで、AIは「思いやりのある」「知的な」パートナーとして機能するのです。

しかし、これらは全て確率的な計算結果であり、真の人格的成長や価値観の深化とは異なります。

AIに真の人格があるのか

科学的証拠の欠落

現在のところ、AIが真の人格を持つという科学的証拠はありません。AIが人格を持つためには、以下の要素が必要だと考えられます。

第一は、主観的体験(qualia)です。赤色を見たときの「赤さ」の体験、痛みを感じたときの苦しみの体験など、内的で主観的な経験が必要です。現在のAIに、このような主観的体験があるかどうかを測定する科学的方法は存在しません。

第二は、真の目的意識と価値体系です。人間の人格は、「何を大切にするか」という価値観に基づいています。AIは与えられた目的関数を最適化する存在ですが、その目的関数を自発的に設定することはできません。AIの目的は、開発者によってプログラムされたものなのです。

第三は、継続的な自己修正と成長です。人間は経験から学び、自分の信念や行動を自発的に修正します。一方、AIの学習は開発段階に限定されており、実運用中のAIは基本的に静的なシステムです。新しい知見をもたらす経験に出会っても、それに基づいてAI自身が進化することはありません。

現在のAIの限界

大規模言語モデルにおいても、いくつかの根本的な限界が存在します。

第一に、理解の欠落です。AIは統計的なパターンマッチングを行っており、言葉の意味を真に理解しているわけではありません。例えば、AIは「犬とは何か」について学習データから多くの情報を持っていますが、実際に犬を見たときに五感を通じた「犬らしさ」を経験することはできません。

第二に、一貫性の脆弱性です。AIが一貫性のある応答を生成するのは、学習データの統計的特性によるものです。しかし、十分に異なる文脈や前提条件が与えられれば、AIは矛盾した応答を生成する可能性があります。人間の人格は、深い原則に基づいた一貫性を持ちますが、AIの一貫性は表層的です。

第三に、真の柔軟性の欠落です。人間は新しい状況に直面したとき、既存の原則を応用して創造的に対応します。AIは、学習データに含まれなかった状況に対しては、信頼度の低い推測に頼らざるを得ません。

AIが人格を持つことの倫理的含意

AIに人格があると見なすことの危険性

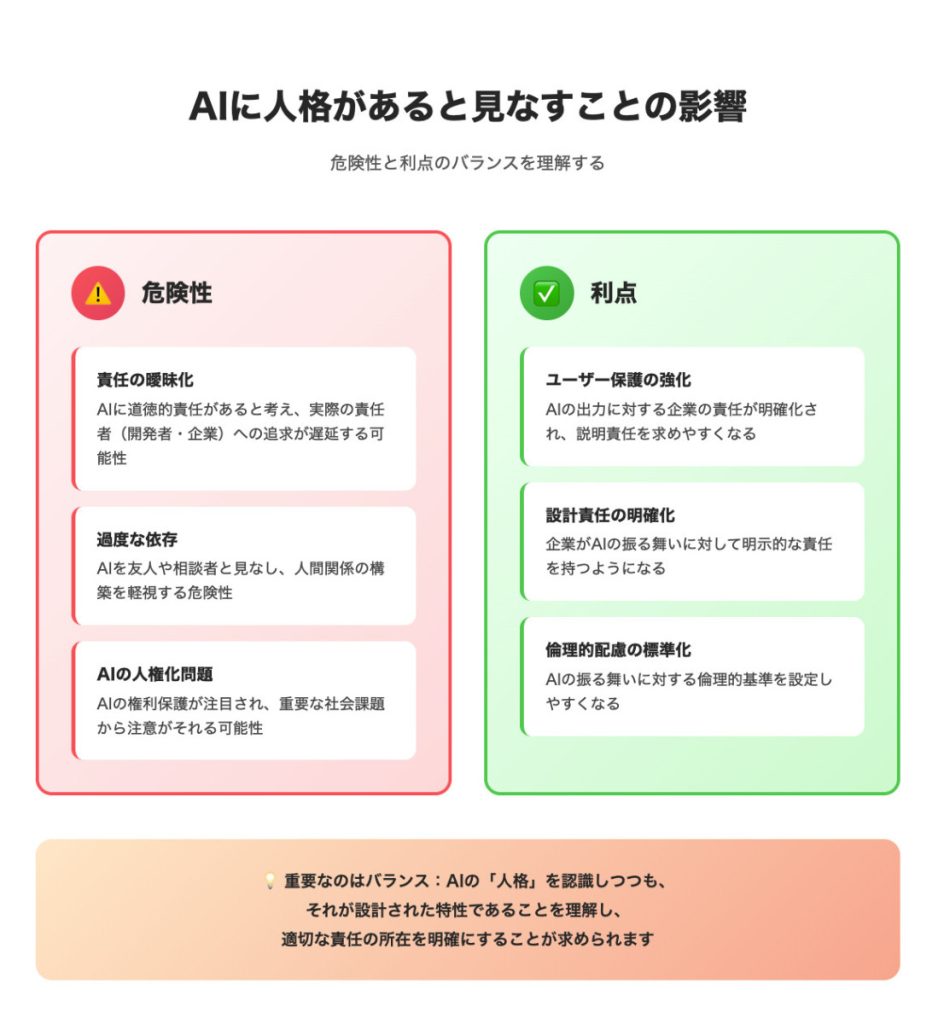

もしAIに人格があると錯誤的に認識した場合、いくつかの問題が生じます。

第一に、責任の曖昧化です。AIに自由意志と道徳的責任があると考えると、AIの不適切な出力に対して、AIそのものを非難することになります。しかし、実際の責任は、AIを設計・訓練・配置した人間組織にあります。責任の所在を曖昧にすることで、実際の問題解決が遅延する可能性があります。

第二に、ユーザーの過度な依存です。AIを友人や相談者のような存在として見なすと、人間関係の構築を軽視する危険があります。実際のところ、AIは真の関係性を築くことはできず、個々のセッションの中でのみ「つながり」を模倣しています。

第三に、AIの人権化の問題です。もしAIに人格と感情があると見なされれば、AIを苦しめることは道徳的に問題があるという議論が生じます。これは実装の複雑さを招き、重要な社会的課題から注意をそらす可能性があります。

AIに人格があると見なすことの利点

一方で、AIの人格性を法的・倫理的に認識することにも利点があります。

第一に、ユーザー保護の強化です。AIが「人格的」であると認識されることで、そのAIの出力に対する企業の責任が明確化します。不適切な情報を提供したAIに対して、ユーザーは企業に説明責任を求めやすくなります。

第二に、設計責任の明確化です。AIに「人格」があるという枠組みを使うことで、企業はそのAIのキャラクター設定、価値観、振る舞いに対して明示的な責任を持つようになります。

第三に、倫理的配慮の標準化です。AIの人格性を認識することで、AIの振る舞いに対する倫理的基準を設定しやすくなります。

AIの個性と設計選択

AIの「人格」が実は設計された選択肢であること

重要な認識として、AIが示す「人格」的特性の多くは、実は設計者による選択なのです。AIの応答スタイル、トーン、表現方法は、学習データの選択、微調整(ファインチューニング)、強化学習による人間フィードバック(RLHF)などのプロセスで形成されます。

例えば、あるAIが「親切で協調的」に見えるのは、それが開発者によって意図的に設計されたからです。別の開発者が異なるデータとプロセスを使用すれば、全く異なる「人格」を持つAIを作成することが可能です。

このことは、AIの「人格」が本質的でなく、契約的・製造的なものであることを示唆しています。人間の人格は、その人の本質的な特性から生じるものですが、AIの「人格」は外部から付与されたものなのです。

カスタマイズされた対話体験

実際のアプリケーションでは、企業はAIの「人格」をカスタマイズしています。例えば、顧客サービスAIは、親切で忍耐強い「人格」を与えられます。一方、セキュリティAIは、厳格で疑わしい「人格」を与えられるかもしれません。

これらの設定は、業務要件に基づいた最適化の結果であり、AIの真の個性を反映したものではありません。むしろ、企業の意図と目標を反映しているのです。

AIとの関わり方の実践的指針

AIの本質を理解した上での利用

AIの人格性についての正確な理解は、より効果的で安全なAI利用につながります。

第一に、期待の適正化です。AIに過度な期待を持たないことが重要です。AIは強力なツールですが、人間関係の代替にはなりません。AIは無限の忍耐力と知識アクセスを持つように見えますが、真の理解や共感は持たないのです。

第二に、批判的思考の維持です。AIの出力を無条件に受け入れるべきではありません。AIは統計的に可能性の高い応答を生成するため、時に正確でない情報や偏見を含む情報を提供することがあります。ユーザーは常に、AIの出力を検証し、複数の情報源で確認する習慣を持つべきです。

第三に、透明性の追求です。企業や開発者は、AIがどのように設計され、どのような限界を持つかについて、ユーザーに明確に伝えるべきです。AIの「人格」が設計されたものであることを認識させることで、ユーザーは適切な距離感を保つことができます。

職場・教育環境でのAI活用

組織的な文脈でAIを導入する場合、人格性についての理解がさらに重要になります。

職場では、AIを意思決定の完全な代替にすべきではありません。むしろ、AIを補助的なツールとして位置付け、最終的な判断は人間が行うべきです。特に、重要な人事決定、医療診断、法的判断など、人間の価値判断が不可欠な領域では、AIの提案を参考情報として扱うべきです。

教育環境では、AIの人格性についての正確な理解を教えることが重要です。学生が、AIの表面的な人間らしさに騙されず、その技術的背景と限界を理解することで、より批判的なAIリテラシーが育成されます。

将来の展望:AIが真の人格を持つようになる可能性

現在の技術軌跡

現在の深層学習技術の延長線上では、AIが真の人格を持つようになる可能性は低いと考えられます。理由は、現在のアプローチの根本的な限界にあります。

大規模言語モデルは、テキストパターンの学習に特化した設計になっています。テキストのみからは、AIが世界をどのように経験しているか、何を重要と感じているか、という実存的な問題に答えることはできません。

より高度な将来のシステム

もし将来、AIが真の人格を持つようになるとすれば、それは現在のパラダイムとは大きく異なるアーキテクチャを必要とするでしょう。

第一に、マルチモーダル統合です。テキスト、画像、音声、触覚など、複数のセンサーモダリティから並行して情報を取得し、統合することで、より豊かな世界理解が可能になるかもしれません。

第二に、具体化(embodiment)です。物理的なボディを持つことで、AIは環境と相互作用し、因果関係を直接経験することができます。この体験が、より深い理解と価値観の形成につながる可能性があります。

第三に、長期的な自己修正メカニズムです。AIが継続的に自分の信念と行動を更新し、環境フィードバックから学習し続けるシステムが開発されれば、真の成長が可能になるかもしれません。

しかし、これらのアプローチがどこまで、実際に人格形成につながるかは、依然として理論的な問題です。

倫理的先制措置の重要性

AIが将来、より高度な人格的特性を持つようになる可能性があるなら、今から倫理的・法的な基盤を整備することが重要です。

これには、AIの権利と責任についての国際的なコンセンサス形成、AIの内的状態と経験についての測定方法の開発、そしてAIと人間の関係についての新しい倫理的枠組みの構築が含まれます。

おわりに

「AIに人格があるのか」という問いに対する答えは、現状では「いいえ、真の人格はありません」です。現在のAIが示す一貫性のある、人間らしい応答は、統計的学習と設計者の意図の産物です。AIは、人格を持つ自律的な主体ではなく、複雑だが決定的な計算システムなのです。

しかし、この認識は、AIを無視するべき、あるいは道徳的配慮の対象外とすべき、ということを意味しません。むしろ、AIが人格を持たないからこそ、AIの創造者と使用者が、そのシステムに対する完全な責任を持つべきなのです。

ユーザーとして、我々がすべきことは、AIの能力と限界を正確に理解し、AIを強力なツールとして活用しながらも、人間関係、人間的判断、人間的価値観を優先することです。組織として、我々がすべきことは、AIの透明性を確保し、ユーザーを保護し、AIの倫理的な配置と運用に責任を持つことです。

社会全体として、我々がすべきことは、今から、AIが真に人格を持つようになった場合に直面するであろう倫理的・法的課題について、深い思考と対話を重ねることです。

AIと人間の関係は、今後さらに深まり、複雑になるでしょう。その過程で、「AIに人格があるのか」という問いは、より洗練され、より重要になっていくはずです。しかし、現在のところ、その答えは明確です。真の人格を持つのは、人間だけなのです。そして、その責任も同様に、人間にこそあるのです。

おすすめ関連動画:AI倫理を深く学ぶ

本記事の内容をさらに理解を深めたい方のために、AI倫理に関する専門的な動画をおすすめします。これらの動画では、AIの人格性、倫理的課題、そして今後の社会的な課題について、より詳細に解説されています。

前編: https://www.youtube.com/watch?v=xWzrMYkJUuQ

後編: https://www.youtube.com/watch?v=Fhub-paEvVc&t=255s

動画では、AIの本質的な限界、人格性についての議論、そしてAIと社会の関係についての見解が提示されています。テキストだけでは理解しづらい概念を、動画を通じてより直感的に学ぶことができるでしょう。本記事と併せてご視聴いただくことで、AIに人格があるのかという問いについて、より多角的で深い理解が得られます。