目次

AI倫理とは何か:社会に影響を与える“見えない判断”

AI倫理とは、人工知能(AI)の開発や活用において、人間の価値観や社会的ルールを尊重しながら、公平・透明・安全に運用するための考え方です。AIが自動で意思決定を行う時代になり、私たちはその結果に日々影響を受けています。例えば求人選考、ローン審査、顔認識、防犯カメラ、SNSのレコメンドなど、AIのアルゴリズムが私たちの生活を支えています。

しかしその一方で、AIの“見えない判断”が社会にゆがみを生む可能性も指摘されています。たとえば、採用AIが過去の人事データから学習した結果、特定の性別や大学出身者を優遇するような偏り(データバイアス)が生まれることがあります。

また、顔認識システムによる誤認や、個人情報の不正利用といったプライバシー侵害のリスクも増加しています。AI倫理とは、こうした技術の“便利さ”と“危うさ”を両立させるためのルール作り。

つまり、「AIを正しく使う力」そのものです。

企業がAIを活用するうえで、この倫理的視点を欠くと、たとえ技術的に優れたサービスであっても、社会的信頼を失う可能性があります。

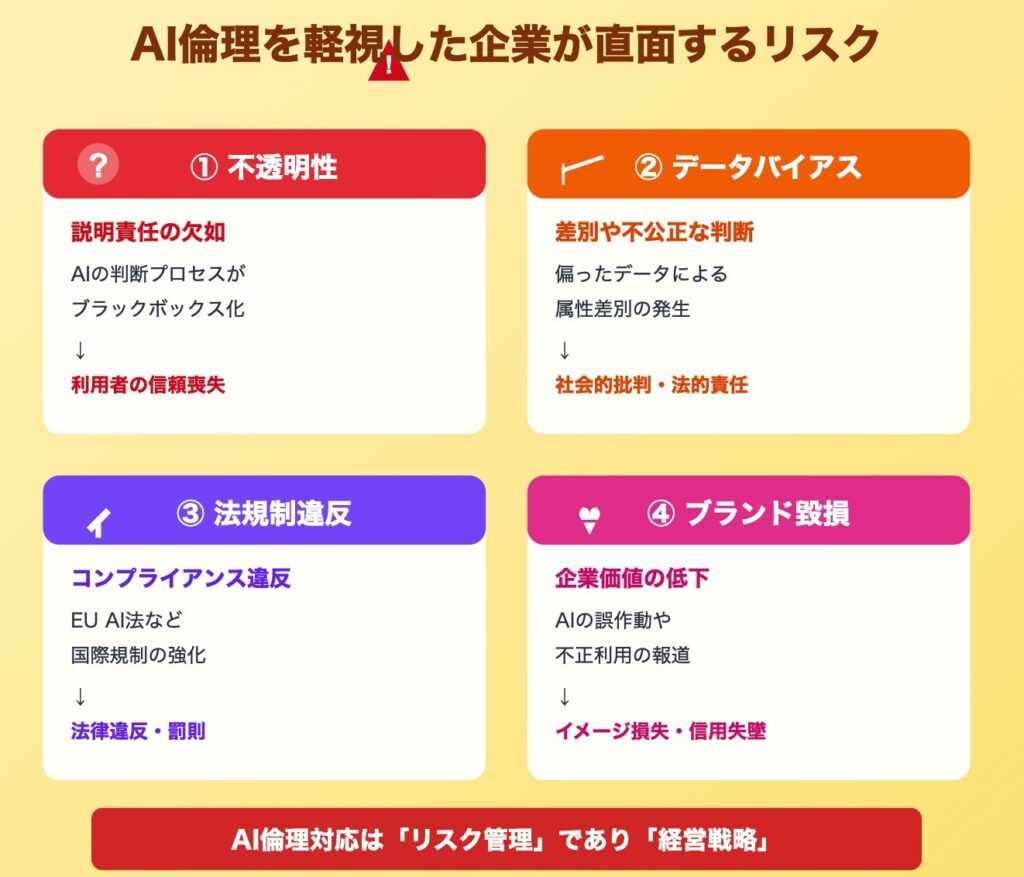

AI倫理を軽視した企業が直面するリスク

AIを導入する企業は年々増えていますが、AI倫理を軽視した運用は次のようなリスクを招きます。

- 判断の不透明性による説明責任の欠如 AIのアルゴリズムは非常に複雑で、意思決定の過程が人間には見えにくい「ブラックボックス化」の問題があります。 たとえ誤判断が起きても「なぜそうなったのか」を説明できなければ、利用者の信頼を失うことになります。

- データバイアスによる差別や不公正 AIは過去のデータを学習しますが、そのデータに偏りがあれば、結果も偏ります。 例えば、人種・性別・年齢・居住地域などによる差別的な判断を下すこともあり得ます。 企業がそれに気づかないままAIを使い続けると、社会的批判や法的責任につながるリスクがあります。

- 法規制やコンプライアンス違反 世界的にAIに関する法規制は強化されています。EUでは「AI法(AI Act)」が制定され、日本でも経産省・総務省・IPAが倫理指針を公表しています。 AI倫理を守らない運用は、今後「法律違反」と見なされる可能性もあります。

- ブランド価値の低下 AIの誤作動や不正利用がニュースになれば、企業のイメージは一瞬で損なわれます。 AIの信頼性は企業の信用そのもの。倫理に配慮した運用こそ、ブランドを守る最大のリスクマネジメントです。

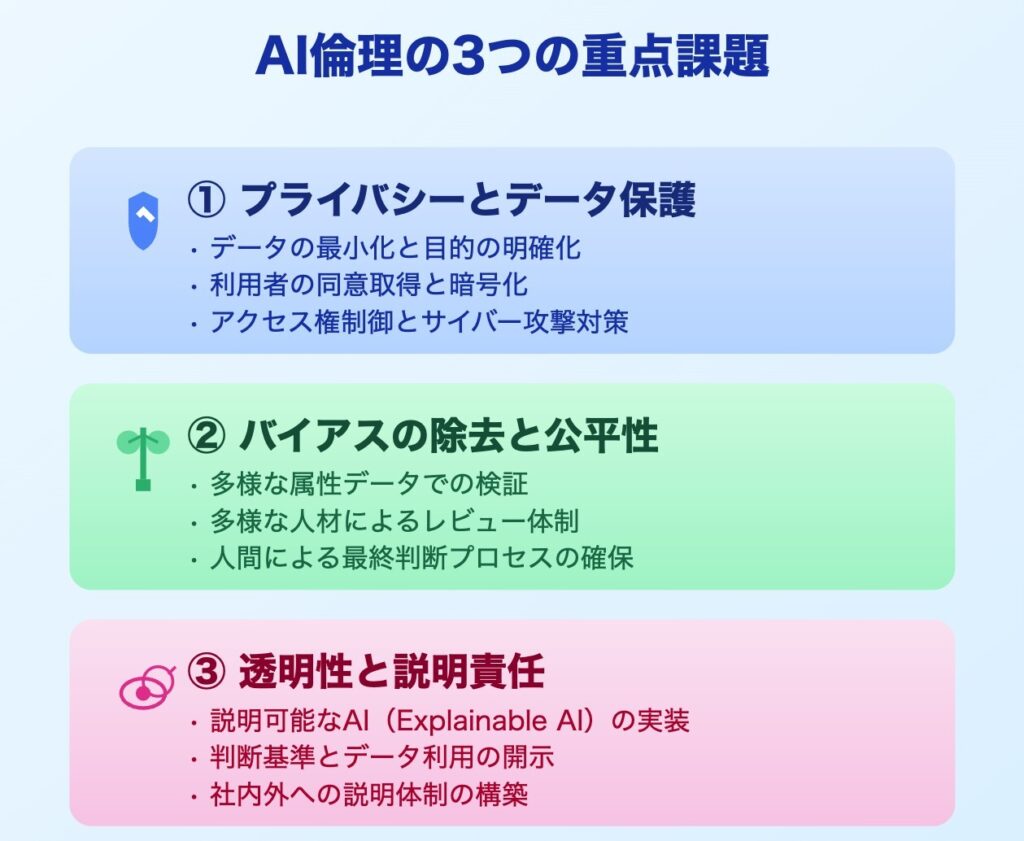

AI倫理を守るための3つの重点課題

① プライバシーとデータ保護

AI活用の根幹はデータです。企業は、個人データの収集・利用・保管・削除の全プロセスで透明性を確保する必要があります。「データの最小化」「目的の明確化」「利用者の同意取得」は基本原則です。

また、アクセス権の制御や暗号化、サイバー攻撃対策などの技術的安全措置も不可欠です。

プライバシー保護は“法令遵守のため”ではなく、“信頼構築のため”に行うという意識が求められます。

② バイアスの除去と公平性

AIが学習するデータには、人間社会の偏りが反映されています。

したがってAI開発では、性別・年齢・国籍などの属性に偏りがないかを常に検証する必要があります。

多様な人材を含むチーム体制を構築し、異なる視点からのレビューを行うことが効果的です。

さらに、AIが出した結果をそのまま採用するのではなく、人間による最終判断プロセスを残すことも大切です。

AIの公平性を担保することは、単なる倫理対応ではなく、「社会的責任を果たす経営判断」でもあります。

③ 透明性と説明責任

Explainable AI(説明可能なAI)とは、AIの判断理由を人間が理解できるようにする取り組みです。

企業は、AIがどんなデータを使い、どんな基準で判断しているのかを開示しなければなりません。これにより、ユーザーや取引先は安心してサービスを利用できます。

また、説明責任は社外だけでなく社内にも必要です。

AIを運用する担当部署や経営層が、システムの仕組みを正しく理解し、問題が起きた際に迅速に対応できる体制を整えることが求められます。

国際的ガイドラインとAIガバナンスの潮流

AI倫理に関する国際的な基準は次の通りです。

- OECD AI原則:人間中心のAI、透明性、公平性、安全性を重視

- EU AI法(AI Act):リスクレベルに応じてAIの利用を規制

- UNESCO AI倫理勧告:人権尊重・持続可能な社会発展を目的とする

これらの国際原則に共通するのは、「AIの開発・利用には人間中心のアプローチが欠かせない」という点です。

企業はこれらを参考に自社のAI倫理ポリシーやガバナンス体制を構築することで、グローバル市場での信頼を高めることができます。

企業が実践すべきAI倫理対応のステップ

- AI倫理方針(ポリシー)の策定 経営層主導で、自社のAI利用における基本原則を明文化します。 「公平性」「透明性」「プライバシー」「安全性」などを基軸に据えると効果的です。

- AI倫理委員会・監査体制の導入 AIプロジェクトを第三者的に監視・評価する仕組みを整えます。 外部有識者を含む委員会を設けることで、社内の思考の偏りを防ぎます。

- 社員教育と倫理リテラシーの向上 AI倫理を理解しないまま技術を扱うと、思わぬトラブルを招きます。 定期的な研修やケーススタディを通じ、社員が倫理的リスクを想定できるようにします。

- 継続的な監視と改善 AIの運用は一度整備したら終わりではありません。 データや環境の変化に応じて、AIの判断が偏っていないかを定期的に検証・改善することが重要です。

日本におけるAI倫理と法的動

日本では政府が「AI戦略2019」を発表し、“人間中心のAI社会”を国家方針として掲げています。

経済産業省・総務省・IPAなどが策定するAIガバナンスガイドラインでは、企業に次の3点を求めています。

- 人間中心の設計と運用

- 透明性と説明責任の確保

- 継続的なリスク管理と改善

また、AI監査制度や倫理認証の整備も進行中で、近い将来、AI倫理への取り組みが取引条件や採用基準になる可能性もあります。

つまり、AI倫理対応は“コスト”ではなく“投資”として考えるべき時代に入っています。

AI倫理の未来:信頼を軸にした新しい競争力へ

AI倫理は単なるルールではなく、企業の信頼と競争力を高める経営資産です。

倫理的なAI運用を行うことで、社会的評価・顧客満足度・従業員の誇りをすべて高めることができます。

今後の企業に求められるのは次の3つの姿勢です。

- 透明で説明可能なAIを構築する姿勢

- 公正・多様なデータ活用を推進する姿勢

- 社会との対話を通じてAIを進化させる姿勢

AIが信頼されるかどうかは、技術力よりも倫理観にかかっています。

AI倫理を実践する企業こそが、次世代の社会に選ばれる存在となるでしょう。

あわせて読みたい